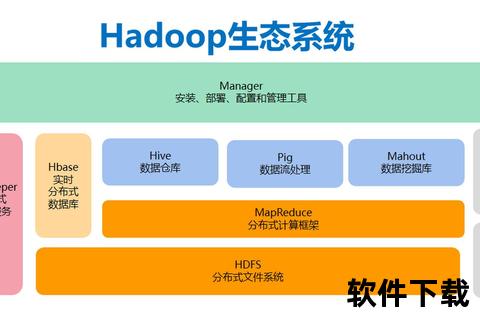

在大数据时代,如何安全高效地处理海量文件是企业的核心诉求。Hadoop作为分布式存储与计算的基石,其文件下载流程的设计与优化直接影响着数据处理的效率与可靠性。本文从技术原理、配置实战、优化策略到安全防护,全面解析Hadoop文件传输的核心要点,为开发者与企业提供深度指南。

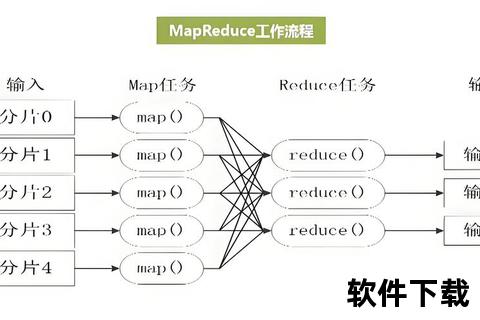

Hadoop的分布式文件系统(HDFS)采用主从架构,由NameNode和DataNode协同工作。文件下载的核心流程可分为以下步骤:

1. 元数据请求:客户端向NameNode发起下载请求,NameNode验证权限后返回文件的元数据(如分块位置、副本分布)。这一过程通过RPC通信实现,涉及路径合法性校验与权限验证。

2. 数据分块获取:客户端根据元数据信息,就近选择DataNode节点建立连接。HDFS采用“机架感知”策略优先访问同一机架节点,减少跨网络带宽消耗。

3. 并行传输与校验:通过FSDataInputStream对象分块读取数据,每个数据块默认以64KB的Packet为单位传输,并在本地生成CRC校验文件,确保数据完整性。

4. 容错机制:若某节点传输失败,客户端自动切换至其他副本节点,并向NameNode报告故障节点,触发后续副本修复。

bash

安装Java环境(需JDK 8+)

sudo apt install openjdk-11-jdk

下载Hadoop安装包(以3.3.6为例)

wget

编辑`core-site.xml`和`hdfs-site.xml`文件,优化下载性能:

xml

bash

hadoop distcp -m 100 hdfs://source/path hdfs://target/path

启用HDFS集中式缓存(Centralized Cache),将热点数据预加载至内存:

bash

hdfs cacheadmin -addPool hotdata -limit 100G

hdfs cacheadmin -addDirective -path /data/hot -pool hotdata

xml

随着AI技术的渗透,Hadoop生态正朝着智能化方向发展。例如:

Hadoop文件下载的高效运作依赖于精准的配置、持续的优化与严密的安全防护。通过本文的实战指南,开发者可系统性掌握从基础原理到高级调优的全链路技能。未来,随着混合云与边缘计算的发展,Hadoop的传输机制将进一步适配多元化场景,成为企业数据战略的核心支撑。