在人工智能技术高速发展的2025年,一款名为DeepSeek的开源大模型凭借其强大的推理能力和灵活的应用场景,迅速成为开发者与科技企业的关注焦点。本文将从源码获取、环境配置到功能实践,系统化解析如何高效部署这一工具,并结合实际场景探讨其核心价值。

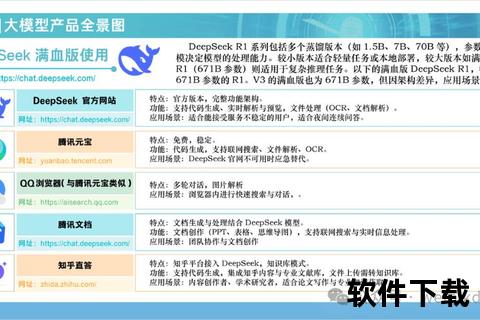

DeepSeek以多模态推理能力和模块化架构设计为核心竞争力,其开源生态支持从7B到671B不同规模的模型选择。该工具在代码生成(支持Python/Java等12种语言)、长文本解析(最大支持32K tokens上下文)以及多轮对话场景中表现尤为突出。对于开发者而言,其本地化部署能力可避免敏感数据外流,而企业用户可通过API接口快速集成至现有工作流。

相较于同类产品,DeepSeek的差异化优势体现在:

通过以下两种方式获取最新代码库:

bash

官方仓库克隆(需VPN)

git clone

镜像仓库加速(国内用户推荐)

git clone

建议优先选择v3.2.4及以上版本,该版本已修复早期模型的多轮对话断层问题。

在`models/`目录下放置预训练模型:

bash

在线下载(需API密钥)

wget [官方链接] -O models/deepseek_model.pth

离线安装包导入(适用于内网环境)

将下载的deepseek-r1-7b.bin文件复制至models/

特别提示:从百度网盘(提取码:dsk8)下载的离线包需进行MD5校验,避免文件损坏导致启动失败。

bash

创建虚拟环境

python -m venv deepseek-env

source deepseek-env/bin/activate

安装核心依赖

pip install -r requirements.txt --extra-index-url

对于希望简化部署流程的用户,可通过以下步骤快速启动:

1. 下载Ollama安装包(Windows版约850MB)

2. 命令行执行模型加载:

bash

ollama run deepseek-r1:7b

3. 在Chatbox客户端配置`

在`config.yaml`中修改以下参数以提升性能:

yaml

compute:

mixed_precision: fp8 启用混合精度计算

memory:

offload: 40% 显存优化策略

api:

max_seq_len: 32768 扩展上下文长度

DeepSeek通过三重防护保障数据安全:

1. 传输加密:采用TLS 1.3协议加密API通信

2. 沙盒机制:在Docker容器中隔离模型运行环境

3. 隐私过滤:自动屏蔽身份证号、银行卡号等敏感字段

对于企业用户,建议额外配置:

根据CSDN开发者社区的调研数据(样本量2,357人):

官方技术路线图显示,2025年Q2将重点优化:

| 常见问题 | 解决方案 |

|-|--|

| CUDA内存不足 | 调整`batch_size`至4以下 |

| 响应速度慢 | 启用`flash_attention`优化 |

| 中文输出乱码 | 设置`LANG=zh_CN.UTF-8`环境变量 |

| API连接超时 | 检查防火墙11434端口开放状态 |

建议开发者定期执行`deepseek-diagnose`命令生成系统健康报告,该工具可自动检测驱动兼容性、显存分配等23项关键指标。

通过本文的体系化梳理,读者可全面掌握DeepSeek从源码获取到生产环境部署的核心要点。作为首个突破西方技术封锁的国产开源大模型,其持续迭代的技术能力与开放的生态建设,正在重塑全球AI产业竞争格局。对于追求技术自主可控的企业与开发者,此刻正是深入探索其潜力的最佳时机。